联邦迁移学习分享(二)

典型的联邦迁移学习定义在纵向联邦学习背景下,但目前在横向联邦学习框架下,应用迁移学习的研究工作也很多。

现有的联邦学习方法已经在保护各参与方数据隐私性的同时保证了较好的模型训练效果,但是大部分方法忽略了不同参与方之间可能存在数据分布的差异。

一个常见的问题是:在同领域(都是金融领域的数据)中,比如大额贷款和小额贷款之间,源任务(小额贷款,有大量标签数据)和目标任务(大额贷款,无标签或者少量标签数据)的数据存在数据分布差异的问题,即data shift。

本问题的目标是:将多个分散的源任务(数据不同享)的知识迁移到目标任务上,以提高目标任务的模型预测准确率。

问题形式化:

问题难点:

1) 不同任务/参与方之间的数据由于隐私问题不能共享,但是现有的迁移学习方法都是同时获取源任务和目标任务的数据,并在此基础上进行知识迁移

2) 每个任务/参与方的模型参数是分开进行训练,并且具有不同的收敛速度,因此不同源任务对目标任务的贡献程度不同

3) 迁移某些不相关的源任务知识可能会导致负迁移

研究方法:联邦对抗迁移学习(UAT)

针对联邦学习中不同参与方存在的数据分布差异问题,我们需要考虑如何在保证隐私安全的情况下,在分布式学习模型的同时减少数据偏移。

具体来说,为了解决源任务和目标任务之间数据分布的差异,从而使知识可以在不同任务之间传递和迁移,本研究拟采用联邦对抗迁移方法(Federated adversarial transfer learning)。该方法旨在无需其他额外数据信息的情况下,通过对抗方法解决联邦学习中的数据分布差异问题,将知识从已有的多个分散的源任务中迁移到具有不同数据分布的目标任务中,以提升目标任务模型的准确率。

具体的系统框架图如下图所示。

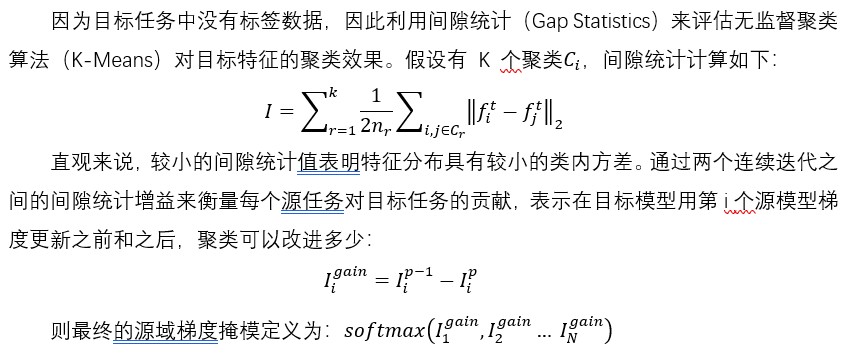

1)注意力机制

为了解决难点二,即不同源任务对目标任务的贡献程度不同,我们利用动态注意力机制对多个分散的源任务进行聚合。动态注意力机制的原理是增加那些对目标任务有利的源任务节点的权重,而限制那些对目标任务不利的源任务节点的权重。

目标任务的模型可表示为多个源任务的模型参数聚合,其中权重α可通过动态注意力模型学习:

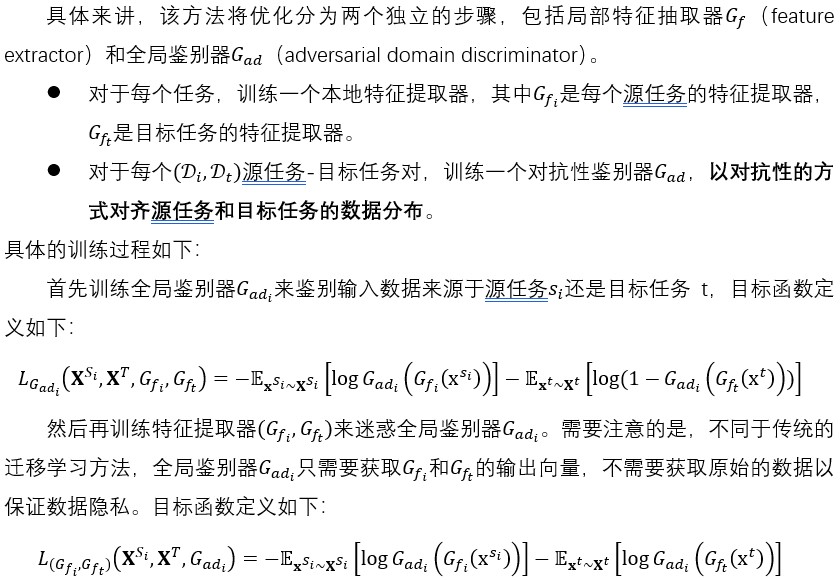

2)联邦对抗对齐

由于源任务和目标任务的数据分布差异,传统联邦学习模型的性能急剧下降。为了解决难点一和三,我们提出联邦对抗性对齐,即对齐分布不同的源任务和目标任务的样本以减小负迁移。

3)表征分解

表征分解通过使用对抗性分解来提取域不变特征。

4)联合优化

该模型采用端到端的训练方式,使用随机梯度下降法训练联邦对齐和表征分解分量。联合对抗性对齐损失和表征分解损失与任务损失一起最小化。

5)预测过程

利用目标任务的预测模型进行预测,不需要源任务的预测模型。

- 发表于 2023-02-13 16:21

- 阅读 ( 2550 )

- 分类:群智能体知识迁移

你可能感兴趣的文章

- 联邦迁移学习分享(一) 2386 浏览

- 现有的几种联邦学习架构(全局聚合模式) 3260 浏览